Inteligjenca Artificiale: Rrjeti Perceptron dhe Rregulli i Mësimit

Një nga arritjet më të rëndësishme të shekullit të njëzetë ishte rregulli Hebian i mësimit që shpjegonte për herë të parë lidhjet që krijohen midis neuroneve kur ata aktivizohen bashkarisht. Ky rregull u prezantua për herë të parë nga Donald Heb (Donald Olding Hebb, 1904–1985) në vitin 1949 në librin “Organizimi i Sjelljes” (origjinali në anglisht: “The Organization of Behavior”). Sipas rregullit të Hebit, kur aksoni i qelizës nervore A ndodhet pranë qelizës nervore B dhe shkakton shkrehje të vazhdueshme të saj, tek njëra apo të dyja këto qeliza ndodh njëfarë rritjeje apo ndryshimi metabolik që e zmadhon kapacitetin e qelizës A për të shkrehur qelizën B. Me fjalë të tjera, ky rregull pohon se lidhja midis dy njësive forcohet nëse rritet shpeshtësia e aktivizimit bashkërisht të tyre dhe shprehet matematikisht me anë të kësaj formule:

e cila përllogarit ndryshimin e peshës sinaptike të neuronit i me sinjal hyrës x, përgjigje y dhe shpejtësi mësimi η. Rregulli i Hebit ishte një nga gurët themelorë të inteligjencës artificiale dhe për pasojë Hebi është cilësuar si babai i rrjeteve nervore. Duhet theksuar ndërkohë që një model paraprak i neuronit ishte formuluar disa vite përpara rregullit të Hebit. Ky model i quajtur MCP (McCulloch and Pitts, 1943) shumonte linearisht hyrjet e peshuara dhe aktivizonte daljen nëse shuma tejkalonte një vlerë pragu. E meta kryesore e modelit MCP ishte fakti që peshat e hyrjeve ishin fikse, në dallim nga peshat e ndryshueshme në modelet e sotëm.

Zhvillimi tjetër i rëndësishëm erdhi në vitin 1958 nga Rozenblat (Frank Rosenblatt, 1928-1971) i cili ndërtoi një pajisje elektronike të quajtur Perceptron (skema e paraqitur te figura në krye). Perceptroni i Rozenblatit ishte në gjendje të mësonte në përputhje me parimin e shoqërimit (për më shumë rreth konceptit të shoqërimit kalo këtu) dhe u përdor fillimisht për të imituar sistemin pamor, pra për të mësuar të dallojë imazhe të ndryshme që i jepen në hyrje. Një avantazh i Perceptronit ishte prezantimi i funksioneve jolineare të aktivizimit. Një ndër më kryesorët është funksioni sigmoidë me formë S-je dhe paraqitje matematike si më poshtë:

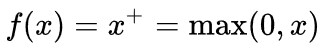

Një tjetër funksion i rëndësishëm aktivizimi i përdorur masivisht në ditët e sotme eshtë Njësia Lineare e Korrigjuar (ang. Rectified Linear Unit) që shënohet ReLU dhe përllogaritet me anë të formulës:

Ky funksion zeron vlerat negative të hyrjes dhe lë siç janë vlerat pozitive. Arsyet e përdorimit të funksioneve jolineare ishin nevoja për “zbutjen” e funksioneve prag për të simuluar më mirë rrjetet nervore biologjike, si dhe përllogartshmëria më e mirë e tyre.

Sikurse Perceptroni modelon një funksion linear të sinjaleve hyrëse, forca e tij paraqitëse kufizohet te kufijtë linearë të vendimmarrjes si ata që kërkojnë veprimet logjike NOT, AND apo OR, por jo XOR apo NXOR të cilët kërkojnë kufij më të sofistikuar të vendimmarrjes. Kjo mangësi e Perceptronit u paraqit dhe u theksua në një artikull të vitit 1969 (Minski and Papert) dhe pati ndikim negativ për shkak se shkaktoi rënie të besimit te rrjetet nervore. Interesi për hulumtime të mëtejshme të rrjeteve nervore ra ndjeshëm deri në fillim të viteve 1980. Kjo erdhi edhe si pasojë e reduktimit të financimeve. Shumë njësi kërkimore në Angli u shpërbënë. Në të njëjtën kohë, DARPA (Defense Advanced Research Projects Agency – Agjencia e Projekteve të Avancuara Kërkimore në Mbrojtje) pezulloi shumë projekte në SHBA. Kjo periudhë e mungesës së përparimit njihet ndryshe si dimri i parë i inteligjencës artificiale.